¿Son verdaderamente fiables los resultados de PISA?

El pasado 25 de octubre tuve la oportunidad de poder asistir a uno de los foros organizados por la Diputación Foral de Gipuzkoa dentro de su estrategia Etorkizuna Eraikiz, mediante la cual se quiere avanzar en la construcción del futuro de Gipuzkoa. El objetivo del foro era el de debatir acerca de cómo se comportan los jóvenes ante los retos, principalmente en el ámbito de la educación, y para ello se contó con la presencia de Nagore Iriberri y Lucas Gortazar, dos personas que conocen muy bien las dificultadas asociadas a la evaluación de la docencia.

En su exposición, tanto Nagore como Lucas se centraron en analizar si los informes de PISA constituyen un buen reflejo de los cambios de la juventud. PISA (Programme for International Student Assessment por sus siglas en inglés) es el principal instrumento empleado en los países de la OCDE para evaluar el grado en el que los sistemas educativos son capaces de mejorar las habilidades y el conocimiento de los estudiantes. Como nuestrxs lectores conocerán, las conclusiones que se emanan de los informes PISA suelen tener una gran repercusión tanto mediática como política. Para ello, se realizan tests homogéneos a lo largo de todos los países de la OCDE, de forma que todxs lxs alumnxs responden a las mismas preguntas, con lo que se garantiza que los resultados sean comparables entre países. En 2015, respondieron a estos tests, que duran aproximadamente 2 horas, unos 28 millones de jóvenes de 15 años en 72 países. Los estudiantes fueron evaluados en ciencias, matemáticas, lectura, resolución de problemas en colaboración y educación financiera. Es decir, en PISA no se tienen en cuenta factores estructurales tales como el gasto por alumno, los niveles de renta, o nivel educativo de los padres, los cuales también pueden incidir sobre el nivel de desempeño del alumnado.

Los últimos resultados disponibles son los del año 2015, y como se recogió en la práctica totalidad de los medios de comunicación, Euskadi no obtuvo la calificación que se esperaba (puedes ver los resultados de 2015 aquí). En el caso vasco, los resultados de PISA son complementados por los diagnósticos que elabora el ISEI-IVEI (Instituto Vasco de Evaluación e Investigación Educativa) en el que se mide el nivel de capacitación de éstos mismos alumnos en comunicación lingüística en euskera, castellano e inglés, su competencia matemática y su competencia científica (puedes encontrar el último informe del ISEI-IVEI para el año 2017 aquí).

Pero, ¿son verdaderamente fiables los resultados de PISA? La presunción que se hace de los informes PISA es que las diferencias observadas en los puntajes reflejan diferencias en las habilidades cognitivas y en el conocimiento general del contenido entre territorios (entre países, o entre regiones dentro de un mismo país). Pero, ¿hasta qué punto estos resultados no están influidos por una serie de variables meramente personales como el nivel de atención del alumnado a la hora de responder a los tests de PISA, su género, o su constancia? No podemos olvidar que aunque sean de obligado cumplimiento, los resultados de PISA no forman parte de la calificación del alumnado; es más, en muchos casos éste no conoce los resultados de sus tests (cuántas preguntas respondieron correcta o incorrectamente).

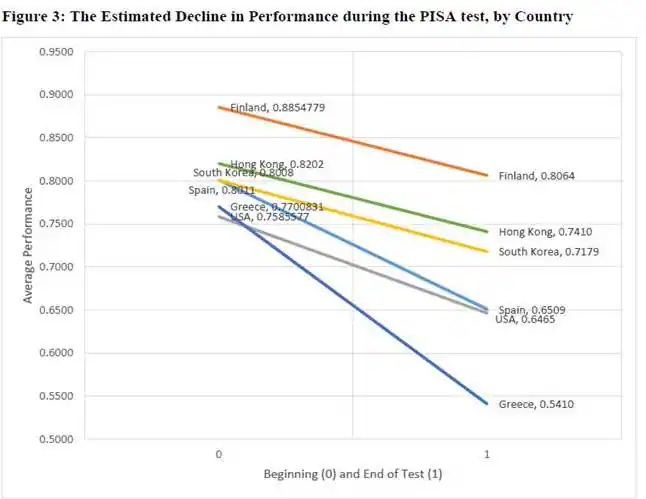

Nagore y Lucas presentaron los resultados de tres investigaciones que me parecieron dignas de mención. En la primera de estas investigaciones Gema Zamarro y sus colegas de la Universidad de Arkansas se preguntan si la variación en los puntajes de las pruebas PISA está asociada con el nivel de esfuerzo que el/la estudiante haya puesto en el test, en lugar del verdadero conocimiento del contenido académico evaluado. Sus resultados (puedes encontrarlos aquí) muestran que el nivel de “aciertos” depende de si una misma pregunta es formulada en el inicio del test o en el final del mismo. Hay que tener en cuenta que para que las muestras sean totalmente aleatorias y comparables, a pesar de que las preguntas incluidas en los tests sean idénticas para una misma cohorte, el orden de las preguntas varía de persona en persona. Sin embargo, este nivel de constancia del alumnado a la hora de responder a las preguntas del tests varía notablemente entre países. Mientras que en Finlandia o Hong Kong el nivel de desempeño del alumnado no varía excesivamente del comienzo al final de la prueba, en países como España, Grecia, o EEUU esta variación es muy superior. En este sentido, a pesar de que las autoras de la investigación no llegan a determinar por qué unos países son más constantes que otros en su esfuerzo al responder al tests, sí concluyen que el nivel de constancia y de esfuerzo del alumnado ayuda a explicar entre el 32 y el 38 por ciento de la variación observada en los puntajes de las pruebas en todos los países.

Fuente: Zamarro et al. (2016)

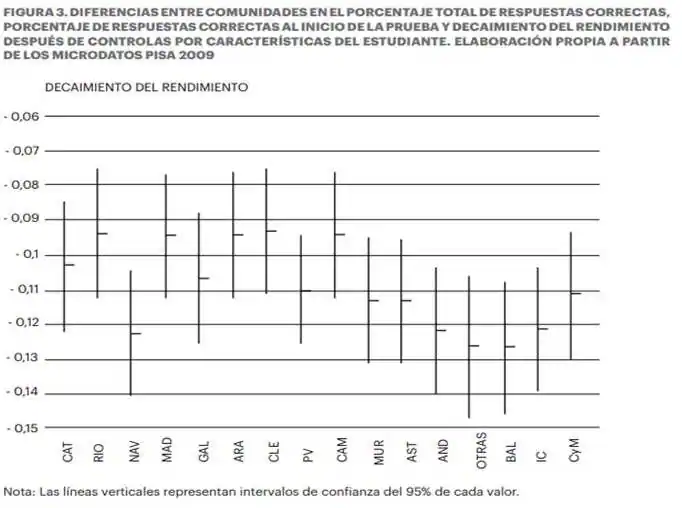

Estos mismos resultados son corroborados para el caso español por Pau Balart y Antonio Cabrales (puedes encontrar sus resultados aquí). Estos autores se centran en analizar las diferencias entre comunidades autónomas en relación con el nivel de constancia mostrado por el alumnado. Como se puede observar en la siguiente figura, el decaimiento en el rendimiento es un problema generalizado en el conjunto de regiones españolas. Sin embargo, al igual que ocurría a escala nacional, a escala regional también se observan diferencias notables. Los autores consideran que la diferencia entre la posición relativa de las comunidades autónomas en los resultados PISA se explican en gran medida por las diferencias en el decaimiento a lo largo del test. En particular, observan que el decaimiento en el rendimiento es de especial relevancia para explicar el buen resultado de las comunidades autónomas a la cabeza de la clasificación (Castilla y León, Aragón, La Rioja y Madrid).

Fuente: Balart y Cabrales (2014)

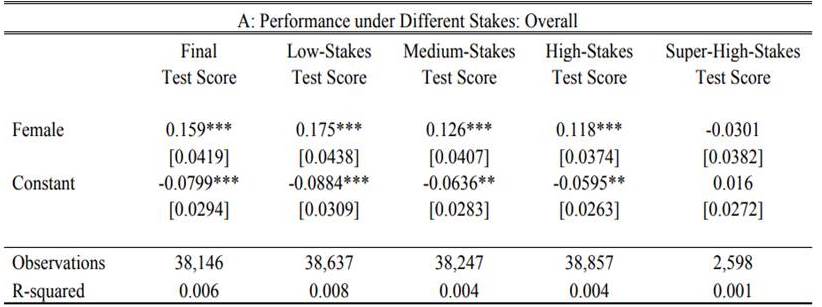

La última de las investigaciones que mencionaron fue una realizada por la propia Nagore conjuntamente con Ghazala Azmat y Caterina Calsamiglia. En ella, las autoras analizan por un lado si las diferencias de género también inciden en los resultados de este tipo de pruebas (puedes encontrar los resultados aquí). Existe una amplia evidencia empírica que muestra cómo estadísticamente, y en término medio, las chicas obtienen mejores calificaciones que los chicos. Pero las autoras van un paso más allá y se preguntan si estas diferencias de género se siguen observando cuando los resultados de las pruebas inciden de forma directa en la calificación final del alumnado. A través de un experimento natural, las autoras observaron que el sesgo de género se observaba de forma clara cuando los resultados de estos tests representaban entre un 5% (low stakes) y un 27% (high stakes) de la nota final. En estos casos en los que el impacto del test en la evaluación final es bajo las estudiantes femeninas superan a los estudiantes varones. Sin embargo, cuando la calificación del test representa el 50% de la calificación final (super high stakes), la brecha de género desaparece.

Fuente: Azmat et al. (2016)

La presentación de estos resultados dio pie a un debate entre los ponentes y los participantes, en el cual salieron a relucir cuestiones como las diferencias entre la motivación intrínseca o extrínseca de los estudiantes en relación con su formación académica, o la creciente cultura antievaluación a la que nos enfrentamos desde las instituciones educativas.

Personalmente, considero que la información que se deriva de este tipo de rankings debería emplearse con mucha cautela, ya que como hemos observado hay una serie de factores que inciden directamente en los resultados, pero que no se controlan ni son susceptibles de poder ser controlados. Soy de los que opina que más allá de la ‘foto finish’ que se pueda derivar de estos rankings, lo que deberíamos plantearnos es el grado en el que este tipo de estudios nos resultan de utilidad como herramienta para la toma de decisiones, en este caso, sobre la política educativa. Creo que el debate no debería ser cuán de bien o de mal salimos en el ranking, sino si los resultados que se derivan del mismo responden a la estrategia (en este caso educativa) que tenemos como país. ¿Qué rol social y económico queremos que desempeñe la educación en nuestro país? Sin embargo, por más que busco, no encuentro respuesta a esta pregunta en la estrategia de Etorkizuna Eraikiz.

Moraleja: si no te gusta la realidad que ves a través de las gafas, en vez de seguir limpiándolas para tratar de ver mejor, trata de transformar la realidad en la que vives (elaboración propia del autor).

Puedes seguirme en Twitter: @jonmizabala